Programmierung eines maschinenlesbaren Nutzungsvorbehalts gegen das Crawling von KI-Anwendungen

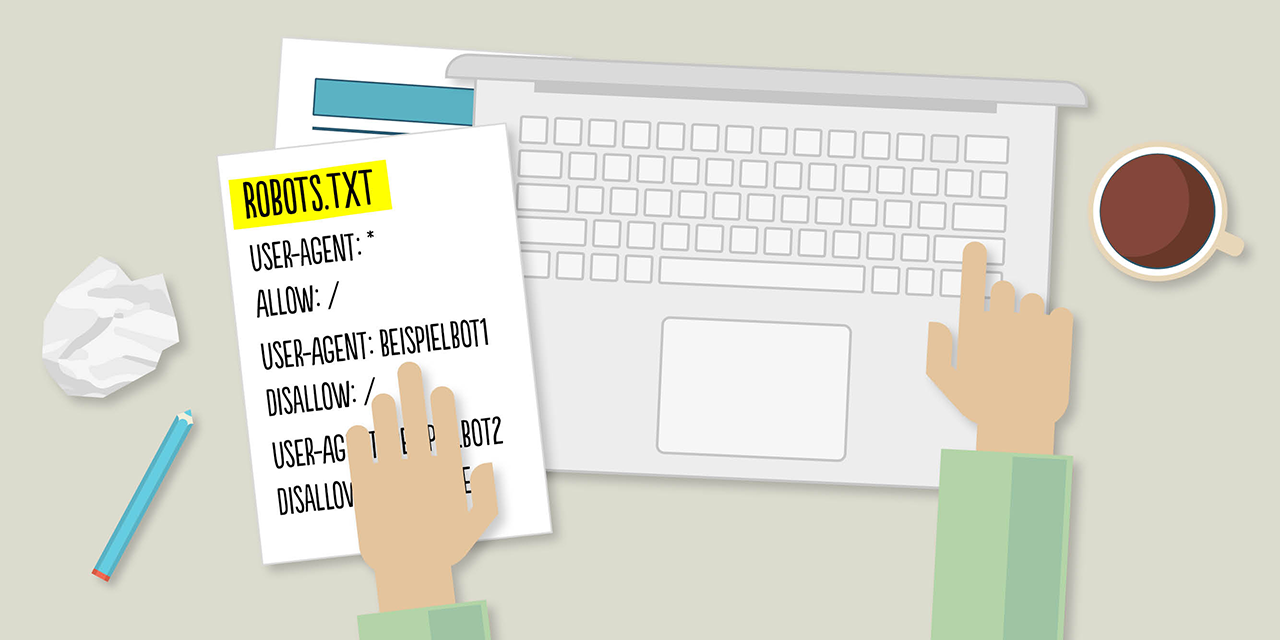

Unser Justiziar Dirk Feldmann bat uns, euch diese Anleitung an die Hand zu geben, wie ihr das »Crawling« von KI-Anwendungen, also das Abgreifen von Inhalten auf eurer Website zwecks Zuführung zu und Training von KI-Algorithmen, technisch unterbinden könnt (sog. »maschinenlesbarer Nutzungsvorbehalt«). Sie basiert auf dem wohl bekanntesten und am weitesten verbreiteten Lösungsansatz, den Nutzungsvorbehalt mittels des »Robot Exclusion Standard« (»RTS«) und der dazugehörigen »robots.txt«-Datei zu programmieren. Solltet ihr beim Programmieren auf Probleme stoßen oder etwas unklar sein, empfehlen wir, euch Rat bei IT-Fachpersonen einzuholen.

1. Wie erstelle und bearbeite ich eine .txt-Datei?

Eine.txt-Datei kann mit gängigen Texteditoren wie

– dem »Editor« für Windows oder

– »TextEdit« für MacOS

erstellt und bearbeitet werden. Diese Programme sind häufig bereits auf den Rechnern vorinstalliert.

Achtung: Es sollten keine Textverarbeitungsprogramme wie Microsoft Word verwendet werden, da diese Programme u.a. die Textdateien in eigenen Formaten speichern oder zufällige Zeichen einfügen können. Dies kann später Probleme mit dem Crawling der Website verursachen.

Wird eine neue Datei über einen Texteditor erstellt, ist es sodann wichtig, die neue Datei so umzubenennen, dass sie den Namen »robots.txt« trägt. Sofern beim Speichern der Datei nach der Codierung gefragt wird, sollten Nutzer*innen die UTF-8-Codierung wählen.

2. Was schreibe ich in die robots.txt-Datei hinein?

Nach Erstellung und Benennung der robots.txt-Datei müssen nun sogenannte »Regelsätze« in der Datei festgelegt werden. Diese Regelsätze weisen die Crawler von KI-Anwendungen an, ob und ggf. welche Teile der eigenen Website ausgelesen werden dürfen.

FREELENS Mitglieder lesbar!

Sie sind noch kein FREELENS Mitglied? Hier finden Sie alle Informationen zum Beitritt